2025年六大查找与下载工具

下载文件听起来像是一件小事,我们每天都会做。但当数量变大时,它一下子就变成了一个小工程。 我在浏览器和下载文件夹里花了很多时间。

在开始之前,我想先说明一点:

- 下载网站资产(图片、CSS、字体、脚本等)

- 和下载网站真正指向的文件(PDF、音频、视频、ZIP、数据集等)

这是两件不同的事。

这篇文章只讨论第二类。开始吧。

1. Download All Files

最适合

想在页面上轻松、快速地查找并下载许多文件的人。非常适合习惯在浏览器中工作、又不想折腾系统工具的用户。

功能

- 扫描当前页面,在清晰的面板中列出所有可下载文件

- 按文件类型、大小、名称排序和筛选,轻松挑选

- 能很好地处理大量 JavaScript 和动态链接的网站

优点

- 可在主流浏览器(Chrome、Firefox、Edge)中快速使用

- 界面简单,支持排序和筛选,也能发现少见的文件类型

- 隐私友好:所有处理都在本地,没有外部服务器,权限极少

缺点

- 使用浏览器内置下载管理器,没有高级功能,如自定义代理或复杂连接规则

- 不能精确控制下载顺序或重连逻辑,除非搭配其他工具

- 不会抓取页面中的嵌入式资产,如内联图片,这是设计上不包含的范围

最终结论

当我只想把页面上所有 PDF 或 ZIP 一次拿走时,我通常会选它。它运行在浏览器内部,权限非常安全。对学生、研究者和忙碌的人来说,从列表到下载只要两次点击,比一堆复杂设置更实用。喜欢极致控制的用户可能仍然更适合系统级下载器。

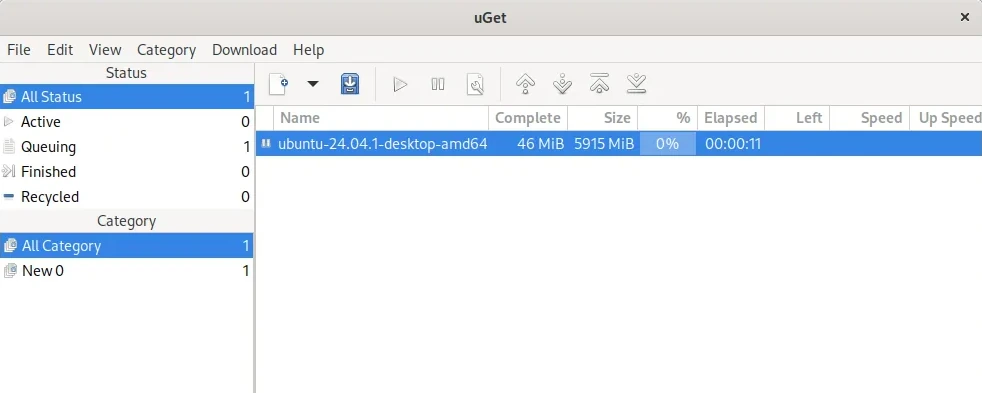

2. uGet

最适合

想要轻量、经典风格系统下载器的用户,尤其是 Linux 用户。比浏览器下载器强,但又不会复杂到吓人。

功能

- 经典界面:队列、暂停、继续、基础调度

- 支持 HTTP、HTTPS、FTP

- 可运行在 Windows、Linux、macOS

优点

- 占用资源极低,界面清晰

- 可跨平台,适合多设备切换

- 能满足日常和部分更高级的需求,包括恢复下载和队列管理

缺点

- 需要安装在系统内,具有较大读写权限

- 缺乏专家级的高级功能,例如自动验证码处理或特定主机插件

- 对复杂的高级文件托管网站支持一般

最终结论

我曾多年把 uGet 当作“中间层工具”。浏览器不够用时,它能很好地接手。因为需要系统安装,我只在信任来源时使用。如果你接受这一点,uGet 是稳定、安静的工具。

3. DownThemAll!

最适合

想对页面内容(链接、图片、资源)进行更精细控制的人。适合不惧选项多、喜欢调节的用户。

功能

- 选择页面中的所有链接或图片,并按照模式过滤

- 支持批量队列、暂停与继续

- 提供强大的过滤器(如只下载图片、只下载特定扩展名)

优点

- 作为浏览器扩展,无需安装程序

- 功能强大,尤其适合处理混合内容的高级用户

- 可下载嵌入与链接文件

缺点

- 界面信息多,新手可能觉得复杂

- 对大量动态 JavaScript 的网站不太稳定

- 权限需求较多,可能让部分用户不放心

最终结论

DownThemAll 是浏览器下载的“高阶版本”。当我需要成批抓老网站图像库时,它非常好用。但我也会提醒朋友:它的界面选项很多,权限提示看着吓人。适合喜欢强控制力的用户。

4. JDownloader

最适合

高级用户、专家、需要处理大型档案、Premium 主机、多段链接的人。

功能

- 大量插件,适配各类文件主机、视频站、受保护链接

- 支持链接解密、多段压缩包解压、自动流程

- 可处理 Premium 账户、等待规则、验证码等

优点

- 灵活、强大,覆盖各种复杂场景

- 能处理来自剪贴板、文本文件、保护页面等“乱七八糟”的链接

- 可长时间运行,适合大型项目级下载任务

缺点

- 需要完整系统安装,权限范围大

- 界面复杂,对新手不友好

- 占用系统资源较高

最终结论

第一次打开 JDownloader,我两分钟就关掉了。但当我真正需要处理大型项目时,我才理解它的强大。如果你经常处理多天的下载任务,它几乎无敌。但请记得:它是系统工具,要确保下载来源可信。

5. HTTrack

最适合

想下载整站或大范围镜像的人。虽然年代久远,但在需要整个站点结构时仍然有用。

功能

- 将完整网站保存到本地

- 支持项目配置,可重复运行

- 细粒度控制路径、类型、主机过滤

优点

- 专业过滤器,可精确控制镜像范围

- 支持深度、代理、多连接等选项

- 项目系统便于复用配置

缺点

- 对现代网站支持不足

- 界面老旧,上手不太友好

- 需要系统安装,对大量 JS 的网站效果差

最终结论

HTTrack 像是老手才懂的工具。对只想下载几个 PDF 的人来说,太重了。但对结构简单的老式网站,它依旧耐用。我只有在需要完整镜像时才用它。

6. Custom Made Script

最适合

开发者、喜欢折腾、想为特定网站设计“完美方案”的用户。

功能

- 针对单个网站结构优化

- 可与其他工具整合,接收文本或数据库中的 URL

- 完全控制日志、节流、文件组织方式

优点

- 很好玩,能练习编程

- 针对某站点时速度极快、稳定

- 逻辑和代码都掌握在自己手里,透明安全

缺点

- 需要编程能力

- 编写、测试、修复要花不少时间

- 过段时间可能忘记参数怎么用了

最终结论

每次写脚本我都会重新认识网络结构。很有成就感,但也耗时。如果你今晚就要下载课程,用脚本并不快。但若你长期处理同一站点,脚本能节省时间。

选择合适的查找与下载工具

你可能已经发现:下载文件比想象中复杂。好消息是:你不需要六个工具。你需要的是一个主力工具加一个备用工具。

以下是我现实中的思考方式。

适合大多数人的一体化方案

如果只能选一个,我会选 Download All Files。

它运行在浏览器中,展示清晰列表,无需安装程序,也不需要学习。对学生、研究者、收藏音乐和文档的用户,都非常合适。

适合大量文件与高级设置

当需求升级,JDownloader 就是专家级选择。

如果你每天处理 Premium 主机、受保护压缩包、几百个链接列表,简单工具不足以应付。它能监控剪贴板、解析链接、处理多段压缩包,是专业用户的强工具。

适合安全与隐私

理论上,自写脚本最安全,因为你掌控所有代码。

但大部分人不会写脚本。

所以实际使用中,我的隐私首选仍然是 Download All Files。它在浏览器有限环境中运行,不接触整个系统,不用外部服务器,权限极小。

适合极简需求

如果工具太复杂,你就不会用。

在极简体验上,Download All Files 几乎无敌。打开页面、点击扩展、选择文件、下载,结束。

适合最大化下载速度

如果你追求极高速度,系统工具更强。

像 JDownloader、HTTrack、uGet 能开很多连接,更适合大文件和长时间下载。但需要更多设置,也有更高系统权限。

最后的想法

下载文件看似简单,但当你要处理大量文件时,它真的会让你忙上一阵子。

我曾经一周需要下载几十篇论文,也有晚上为了保存一个快下线的剧集忙到很晚。在这些场景里,一百次点击与两次点击完全是两种体验。

没有一个工具能适合所有情况。这是我用完所有工具后得到的真正体会。

希望这篇对比能帮你选到最适合你的工具。如果你找到我没提到的小技巧,我也很想 someday 听你分享。